记一下机器学习笔记 Rosenblatt感知机

1入ML深似海啊…

这里主要是《神经网络与机器学习》(Neural Networks and Learning Machines,以下简称《神机》)的笔记,和1些周志华的《机器学习》的内容,可能夹杂有自己的吐槽,和自己用R语言随意撸的实现。

话说这个《神经网络与机器学习》还真是奇书,不知是作者风格还是翻译问题,1眼望去看不到几句人话(或许是水利狗看不懂),感觉我就是纯买来自虐的。

作为开始固然是最古老的机器学习算法之1,神经网络的板砖感知机,对应《神机》的第1章。

由于是Rosenblatt提出的模型所以就加上了他名字作为前缀。这是1个有监督学习,也就是不但给出自变量还要给出结果值让机器自个拟合的模型,而且是1个2分类模型。再说清楚1点,这玩意只能分线性可分的样本,也就是对2维的数据,它只能弄1条直线把样本分开,对3维的数据,只能弄个平面把样本分开。

所以像竟然连异或运算都不能弄之类的对它的吐槽历来很多。

感知机概念

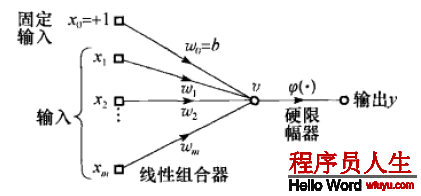

感知机由1个线性组合器(说白了就是把1系列输入值加权求和)和1个硬限幅器(说白了就是拿前面的求和取符号)组成。具体模样参考下图(来自《神机》):

我们将1组输入值记为

加权和

然后对这个

可以用逼格更高的矩阵情势简洁表示:

那末每组输入值

又或从几何角度理解:在m维空间上有这么1个超平面

所以说样本必须线性可分的才可以被它分类。

感知机收敛定理

然后这玩意的学习方式是不断的误差修正,称为误差修正学习原则。

当1个样本被正确分类的时候就没啥事,要是被毛病分类了就根据样本的各个份量调剂权值,就这样把整套样本丢进去跑几趟直到误差收敛为止。

现在干脆把偏置

然后根据迭代步数n把权值向量这样定义:

其中