select的限制

用select实现的并发服务器,能到达的并发数1般受两方面限制:

1)1个进程能打开的最大文件描写符限制。这可以通过调剂内核参数来改变。可以通过ulimit -n(number)来调剂或使用setrlimit函数设置(需要root权限),但1个系统所能打开的最大数也是有限的,跟内存大小有关,可以通过cat /proc/sys/fs/file-max 查看。

2)select中的fd_set集合容量的限制(FD_SETSIZE,1般为1024),这需要重新编译内核才能改变。

对第1个限制:

nclude

#include

int getrlimit(int resource, struct rlimit *rlim);

int setrlimit(int resource, const struct rlimit *rlim);

其中,resource的1个取值 RLIMIT_NOFILE

代表指定比进程可打开的最大文件描写词大1的值,超越此值,将会产生EMFILE毛病。

rlim:描写资源软硬限制的结构体,原型以下

struct rlimit {

rlim_t rlim_cur; /* Soft limit */

rlim_t rlim_max; /* Hard limit (ceiling for rlim_cur) */

};

返回说明:

成功履行时,返回0。失败返回⑴,errno被设为以下的某个值

EFAULT:rlim指针指向的空间不可访问

EINVAL:参数无效

EPERM:增加资源限制值时,权能不允许

软限制是1个建议性的, 最好不要超出的限制, 如果超出的话, 系统可能向进程发送信号以终止其运行.

而硬限制1般是软限制的上限;

|

resource可用值

|

|

RLIMIT_AS

|

进程可用的最大虚拟内存空间长度,包括堆栈、全局变量、动态内存

|

|

RLIMIT_CORE

|

内核生成的core文件的最大大小

|

|

RLIMIT_CPU

|

所用的全部cpu时间,以秒计算

|

|

RLIMIT_DATA

|

进程数据段(初始化DATA段, 未初始化BSS段和堆)限制(以B为单位)

|

|

RLIMIT_FSIZE

|

文件大小限制

|

|

RLIMIT_SIGPENDING

|

用户能够挂起的信号数量限制

|

|

RLIMIT_NOFILE

|

打开文件的最大数目

|

|

RLIMIT_NPROC

|

用户能够创建的进程数限制

|

|

RLIMIT_STACK

|

进程栈内存限制, 超过会产生SIGSEGV信号

|

进程的资源限制通常是在系统初启时由0#进程建立的,在更改资源限制时,须遵守以下3条规则:

1.任何1个进程都可将1个软限制更改成小于或等于其硬限制。

2.任何1个进程都可下降其硬限制值,但它必须大于或等于其软限制值。这类下降,对普通用户而言是不可逆反的。

3.只有超级用户可以提高硬限制。

/**示例: getrlimit/setrlimit获得/设置进程打开文件数目**/

int main()

{

struct rlimit rl;

if (getrlimit(RLIMIT_NOFILE, &rl) == ⑴)

err_exit("getrlimit error");

cout << "Soft limit: " << rl.rlim_cur << endl; cout << "Hard limit: " << rl.rlim_max << endl; cout << "------------------------->" << endl; rl.rlim_cur = 2048; rl.rlim_max = 2048; if (setrlimit(RLIMIT_NOFILE, &rl) == ⑴) err_exit("setrlimit error"); if (getrlimit(RLIMIT_NOFILE, &rl) == ⑴) err_exit("getrlimit error"); cout << "Soft limit: " << rl.rlim_cur << endl; cout << "Hard limit: " << rl.rlim_max << endl; }

测试最多可以建立多少个链接,下面是客户真个代码:

#include

#include

#include

#include

#include

#include

#include

#include

#include

#define ERR_EXIT(m)

do

{

perror(m);

exit(EXIT_FAILURE);

} while( 0)

int main( void)

{

int count = 0;

while( 1)

{

int sock;

if ((sock = socket(PF_INET, SOCK_STREAM, IPPROTO_TCP)) < 0) { sleep( 4); ERR_EXIT( "socket"); } struct sockaddr_in servaddr; memset(&servaddr, 0, sizeof(servaddr)); servaddr.sin_family = AF_INET; servaddr.sin_port = htons( 5188); servaddr.sin_addr.s_addr = inet_addr( "127.0.0.1"); if (connect(sock, ( struct sockaddr *)&servaddr, sizeof(servaddr)) < 0) ERR_EXIT( "connect"); struct sockaddr_in localaddr; socklen_t addrlen = sizeof(localaddr); if (getsockname(sock, ( struct sockaddr *)&localaddr, &addrlen) < 0) ERR_EXIT( "getsockname"); printf( "ip=%s port=%d ", inet_ntoa(localaddr.sin_addr), ntohs(localaddr.sin_port)); printf( "count = %d ", ++count); } return 0; }

我们来看1下server端输出:

recv connect ip=127.0.0.1 port=57430

count = 2039

recv connect ip=127.0.0.1 port=57431

count = 2040

recv connect ip=127.0.0.1 port=57432

count = 2041

recv connect ip=127.0.0.1 port=57433

count = 2042

recv connect ip=127.0.0.1 port=57434

count = 2043

recv connect ip=127.0.0.1 port=57435

count = 2044

recv connect ip=127.0.0.1 port=57436

accept error: Too many open files

解析:对客户端,最多只能开启1021个连接套接字,由于总共是在Linux中最多可以打开1024个文件描写如,其中还得除去0,1,2。而服务器端只能accept 返回1020个已连接套接字,由于除0,1,2以外还有1个监听套接字listenfd,客户端某1个套接字(不1定是最后1个)虽然已建立了连接,在已完成连接队列中,但accept返回时到达最大描写符限制,返回毛病,打印提示信息。

client在socket()返回⑴是调用sleep(4)解析

当客户端调用socket准备创建第1022个套接字时,如上所示也会提示毛病,此时socket函数返回⑴出错,如果没有睡眠4s后再退出进程会有甚么问题呢?如果直接退出进程,会将客户端所打开的所有套接字关闭掉,即向服务器端发送了很多FIN段,而此时或许服务器端还1直在accept ,即还在从已连接队列中返回已连接套接字,此时服务器端除关心监听套接字的可读事件,也开始关心前面已建立连接的套接字的可读事件,read 返回0,所以会有很多 client close 字段参杂在条目的输出中,还有个问题就是,由于read 返回0,服务器端会将本身的已连接套接字关闭掉,那末或许刚才说的客户端某1个连接会被accept 返回,即测试不出服务器端真实的并发容量;

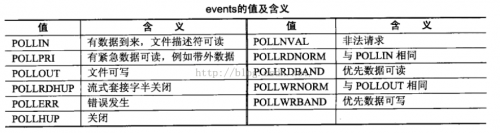

poll调用

poll没有select第2个限制, 即FD_SETSIZE的限制, 不用修改内核,但是第1个限制暂时还是没法避免的;

#include

int poll(struct pollfd *fds, nfds_t nfds, int timeout);

参数nfds: 需要检测事件的个数, 结构体数组大小(也可表示为文件描写符个数)(The caller should specify the number of items in the fds array in nfds.)

参数timeout: 超时时间(单位milliseconds, 毫秒),若为⑴,表示永不超时。

poll 跟 select 还是很相似的,比较重要的区分在于poll 所能并发的个数跟FD_SETSIZE无关,只跟1个进程所能打开的文件描写符个数有关,可以在select 程序的基础上修改成poll 程序,在运行服务器端程序之前,使用ulimit -n 2048 将限制改成2048个,注意在运行客户端进程的终端也需更改,由于客户端也会有所限制,这只是临时性的更改,由于子进程会继承这个环境参数,而我们是在bash命令行启动程序的,故在进程运行期间,文件描写符的限制为2048个。

使用poll 函数的服务器端程序以下,和select大概用法差不多:

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include "read_write.h"

#define ERR_EXIT(m)

do {

perror(m);

exit(EXIT_FAILURE);

} while ( 0)

int main()

{

int count = 0;

signal(SIGPIPE, SIG_IGN);

int listenfd; //被动套接字(文件描写符),即只可以accept, 监听套接字

if ((listenfd = socket(PF_INET, SOCK_STREAM, IPPROTO_TCP)) < 0) // listenfd = socket(AF_INET, SOCK_STREAM, 0) ERR_EXIT( "socket error"); struct sockaddr_in servaddr; memset(&servaddr, 0, sizeof(servaddr)); servaddr.sin_family = AF_INET; servaddr.sin_port = htons( 5188); servaddr.sin_addr.s_addr = htonl(INADDR_ANY); int on = 1; if (setsockopt(listenfd, SOL_SOCKET, SO_REUSEADDR, &on, sizeof(on)) < 0) ERR_EXIT( "setsockopt error"); if (bind(listenfd, ( struct sockaddr *)&servaddr, sizeof(servaddr)) < 0) ERR_EXIT( "bind error"); if (listen(listenfd, SOMAXCONN) < 0) //listen应在socket和bind以后,而在accept之前 ERR_EXIT( "listen error"); struct sockaddr_in peeraddr; //传出参数 socklen_t peerlen = sizeof(peeraddr); //传入传出参数,必须有初始值 int conn; // 已连接套接字(变成主动套接字,便可以主动connect) int i; struct pollfd client[ 2048]; int maxi = 0; //client[i]最大不空闲位置的下标 for (i = 0; i < 2048; i++) client[i].fd = - 1; int nready; client[ 0].fd = listenfd; client[ 0].events = POLLIN; while (1) { /* poll检测[0, maxi + 1) */ nready = poll(client, maxi + 1, - 1); if (nready == - 1) { if (errno == EINTR) continue; ERR_EXIT( "poll error"); } if (nready == 0) continue; //如果是监听套接口产生了可读事件 if (client[0].revents & POLLIN) { conn = accept(listenfd, ( struct sockaddr *)&peeraddr, &peerlen); //accept不再阻塞 if (conn == - 1) ERR_EXIT( "accept error"); for (i = 1; i < 2048; i++) { if (client[i].fd < 0) { client[i].fd = conn; if (i > maxi)

maxi = i;

break;

}

}

if (i == 2048)

{

fprintf(stderr, "too many clients

");

exit(EXIT_FAILURE);

}

printf( "count = %d

", ++count);

printf( "recv connect ip=%s port=%d

", inet_ntoa(peeraddr.sin_addr),

ntohs(peeraddr.sin_port));

client[i].events = POLLIN;

if (--nready <= 0) continue; } for (i = 1; i <= maxi; i++) { conn = client[i].fd; if (conn == - 1) continue; //已连接套接口产生了可读事件 if (client[i].revents & POLLIN) { char recvbuf[ 1024] = { 0}; int ret = readline(conn, recvbuf, 1024); if (ret == - 1) ERR_EXIT( "readline error"); else if (ret == 0) //客户端关闭 { printf( "client close "); client[i].fd = - 1; close(conn); } fputs(recvbuf, stdout); writen(conn, recvbuf, strlen(recvbuf)); if (--nready <= 0) break; } } } return 0; } /* poll 只受1个进程所能打开的最大文件描写符限制,这个可使用ulimit -n调剂 */

可以看到现在最大的连接数已是2045个了,虽然服务器端有某个连接没有accept 返回。即poll 比 select 能够承受更多的并发连接,只受1个进程所能打开的最大文件描写符个数限制。可以通过ulimit -n 修改,但1个系统所能打开的文件描写符个数也是有限的,这跟系统的内存大小有关系,所以说也不是可以无穷地并发,我们在文章的开始也提到过,可使用 cat /proc/sys/fs/file-max查看1下本机的容量。